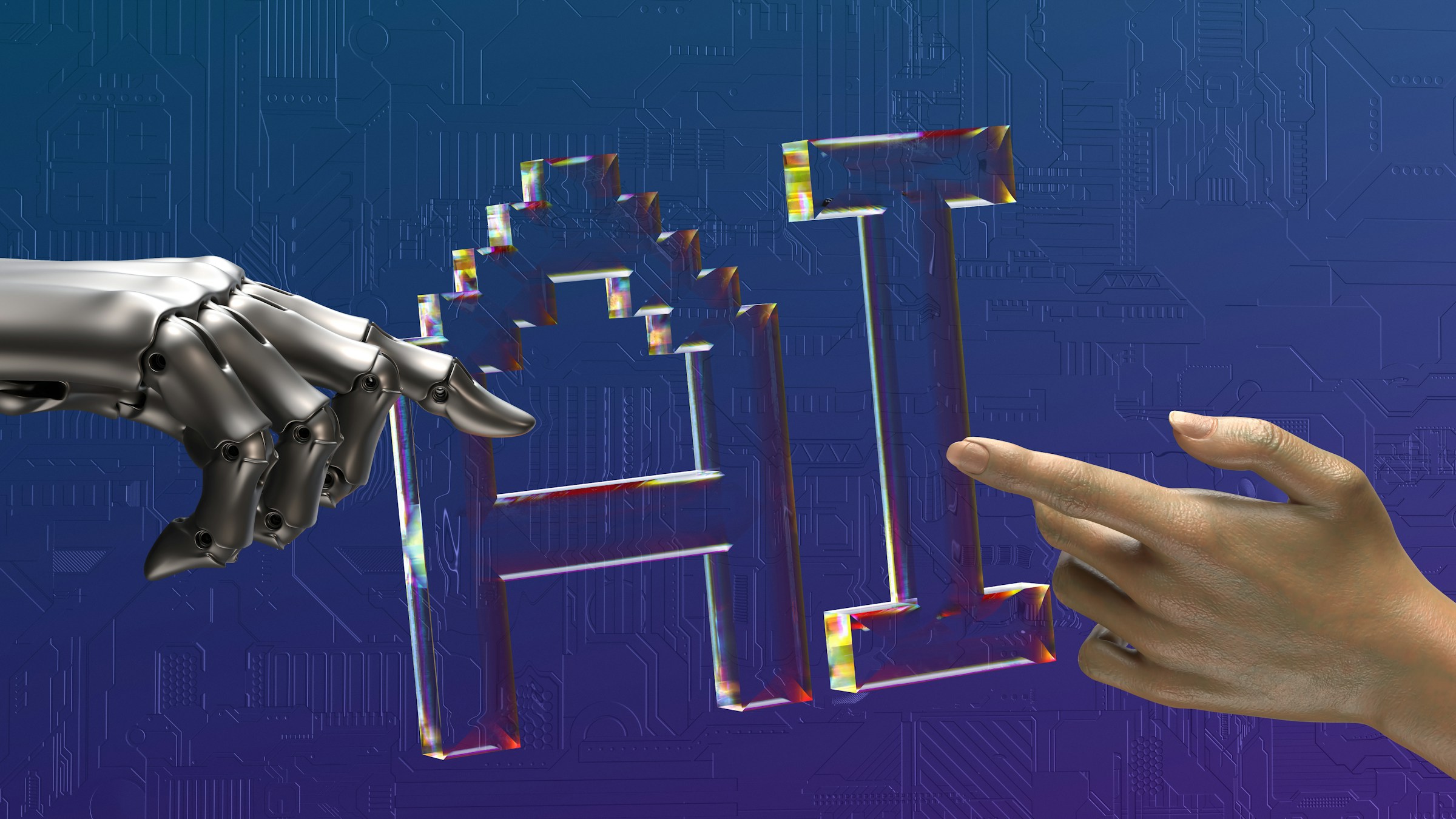

事件焦点:从争议到落地的另一种回答

近一周以来,“Scaling Law撞墙论”成为全球AI讨论焦点。就在部分技术领军者认为模型扩展接近极限之时,DeepSeek选择以V3.2与V3.2-Speciale重塑讨论方向——不是质疑理论,而是用实践证明规模仍具可挖掘空间。

Scaling Law争议背后的技术逻辑

Ilya Sutskever指出,预训练数据不足、模型臃肿难带来质变,暗示“扩展时代”终将离场。DeepSeek则提出完全不同的经验:训练后瓶颈应由优化方法与数据解决,而非简单等待更好的基座。研究团队强调,“遭遇瓶颈并不意味着道路终止,而是提示应改变突破方式”。这使Scaling讨论出现了“不是规模消失,而是规模换道”的新视角。

V3.2的能力定位与技术创新

作为日常主力模型,V3.2在推理与代码任务上稳步接近GPT-5,同时以DSA稀疏注意力实现更长上下文的高效计算。其独特之处在于将“思考模式”与“工具调用”结合,让推理链路不再封闭。通过构建覆盖1800+环境、85000+复杂任务的Agent训练流水线,V3.2在开源评测中展现出真实泛化能力,而非榜单优化。

V3.2-Speciale的深度推理路线

Speciale承担模型体系中的“极限推理与自我验证”任务。它允许大幅增加推理链路长度,使模型能够在高复杂度场景中形成多次验证、多轮推导的能力。深度推理带来Token量的大幅上涨,但由于DSA架构的效率提升,其成本反而显著下降。例如在Codeforces场景中,Speciale输出77k tokens,达到Gemini的3.5倍,但推理成本却远低于同档竞品。

未来预期与行业推测

DeepSeek在报告中指出,目前知识覆盖度落后于Gemini 3.0 Pro,未来版本将回到“扩大预训练”的主线补齐差距。观察其过去一年在V3基座上完成的多模态一体化架构、视觉压缩记忆与强化学习工程化路径,有行业预判认为:当预训练算力补齐后,DeepSeek可能在V4或R2中实现更大幅度跃迁。

结尾观察:方法论的重要性

V3.2系列给出的答案并非简单反驳Scaling Law,而是一套新的工程化路线:用架构创新解决长上下文瓶颈,用强化学习解决推理深度,用过程监督解决自我验证,用算力扩大解决知识缺口。这套思路展示了一条不同于以往的模型演化路径,也让关于“规模是否终结”的争论重新回到技术本质。

© 版权声明

本内容由 AI 生成,仅供参考,不构成新闻报道。

相关文章

暂无评论...