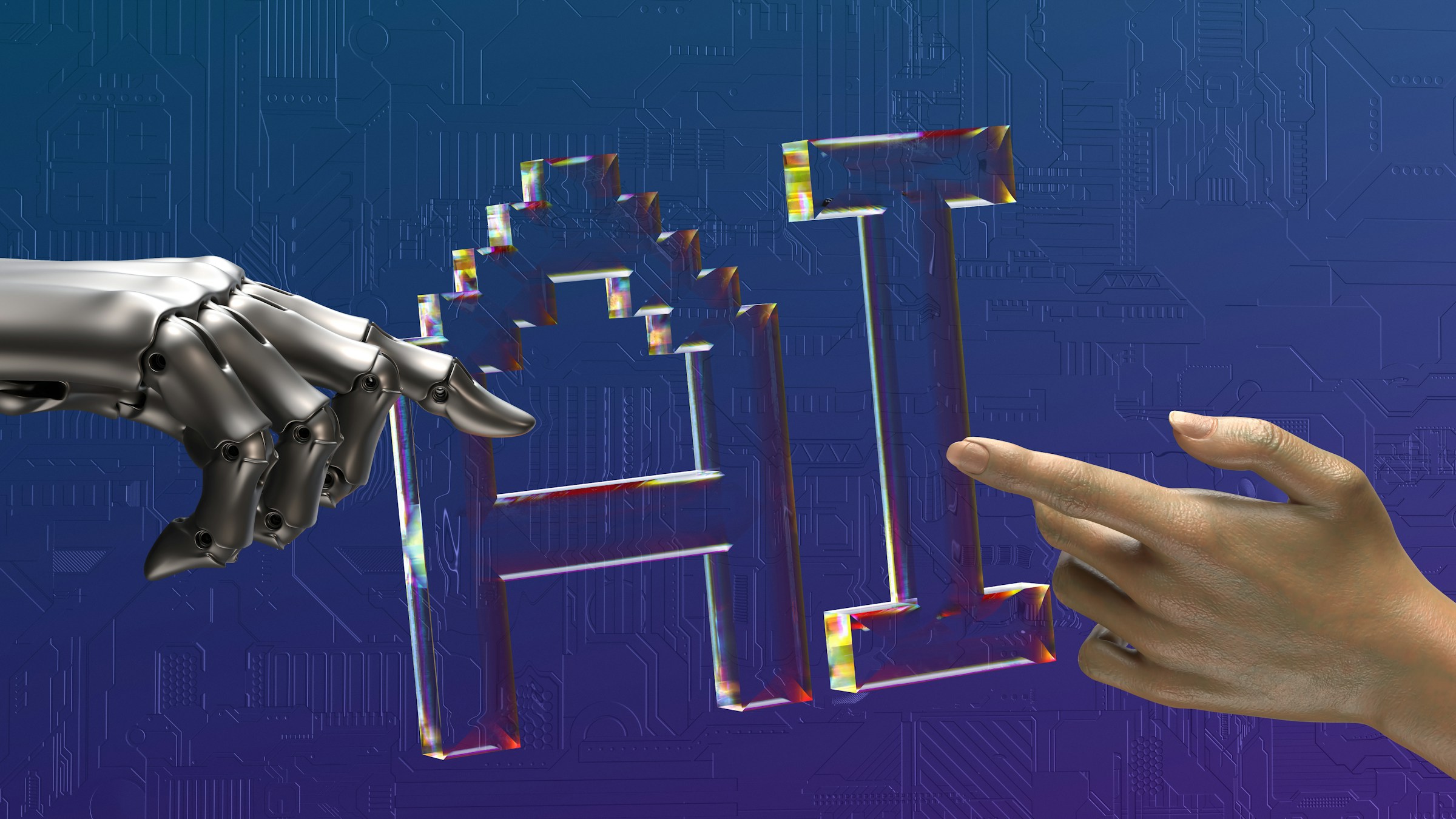

旗舰模型传闻引发广泛讨论

围绕DeepSeek新一代模型DeepSeek-V4的消息,近期在技术圈内持续发酵。相关爆料称,该模型或将在春节前后发布,并在代码任务中实现对Claude与GPT系列的超越。虽然DeepSeek官方暂未表态,但这一消息已引发开发者与研究人员的高度关注。

沉默背后的技术铺垫

在未作公开回应的同时,DeepSeek近期的研究输出却异常密集。多篇论文接连发布,显示其正在为下一代模型进行系统性技术铺垫。其中,与北京大学联合完成的最新研究,被认为是理解V4能力边界的重要窗口。

Engram概念首次系统亮相

在《Conditional Memory via Scalable Lookup》论文中,DeepSeek提出了名为Engram的条件记忆机制。这一设计试图重新定义模型在推理阶段如何“记住”和“调用”信息,为解决大模型推理效率问题提供新的思路。梁文锋的署名,也进一步强化了该研究与核心模型研发之间的关联性。

以“记忆检索”替代“深度计算”

论文指出,现有大模型在回答问题时,往往通过密集计算逐步拼接结果,本质是在用计算模拟记忆。DeepSeek认为,这种方式在代码与复杂逻辑任务中效率并不理想。Engram通过对N-gram结构的工程化改造,引入哈希映射与上下文门控机制,使模型能够快速定位并复用高频语义单元。这一变化,使模型在处理代码时更接近“程序员使用IDE”的工作方式。

对超大规模模型的现实意义

除性能提升外,Engram机制在系统层面的意义同样突出。论文实验构建了千亿级参数规模的Engram词表,并将其部署在CPU内存中。得益于计算与数据传输的重叠设计,推理阶段的整体吞吐量损耗控制在极低水平。这意味着,未来运行超大模型可能不再完全依赖昂贵的显存资源,从而显著降低部署与维护成本。

实验数据支撑性能飞跃判断

在多项评测任务中,Engram-27B在推理、代码、数学与知识密集型任务上均明显优于传统MoE架构模型,尤其在长文本与复杂逻辑场景中优势突出。研究人员指出,Engram减少了无效计算,使模型深层结构能够更专注于推理本身。这一结论,与外界关于V4“回答更有条理、逻辑更强”的爆料高度一致。

结语:V4是否到来,答案或已写在论文中

尽管DeepSeek-V4尚未官宣,但从Engram论文所展示的技术路径来看,新一代模型的能力边界已开始显现。若相关机制在V4中全面落地,其在代码与推理领域引发新一轮竞争并非空谈。随着春节临近,V4是否亮相,或将很快揭晓。

© 版权声明

本内容由 AI 生成,仅供参考,不构成新闻报道。

相关文章

暂无评论...